MODELO DE PROBABILIDAD DE UNION BASADO EN FRASES PARA TRADUCCION AUTOMATICA ESTADISTICA.

Procedimiento implementado por ordenador para generar un modelo de probabilidad conjunta basado en frases a partir de un cuerpo paralelo que comprende una pluralidad de frases en el idioma fuente y una pluralidad de frases correspondiente en el idioma de destino;

comprendiendo el procedimiento:

a) definir a partir del cuerpo paralelo n-gramas de alta frecuencia (vec(ei) en E, y (vec(fi) en F, donde E y F comprenden frases en el idioma fuente y de destino, respectivamente;

b) obtener una distribución de probabilidad conjunta t inicial basada en la frase, mediante:

i) tomar, para cada par de frases (E, F) en el cuerpo, tres productos cartesianos de n-gramas (vec(ei) en E, y (vec(fi) en F;

ii) determinar, para cada par de n-gramas (ei, fi) en el producto cartesiano, un recuento t dado por la expresión:

Tipo: Patente Internacional (Tratado de Cooperación de Patentes). Resumen de patente/invención. Número de Solicitud: PCT/US03/09771.

Solicitante: UNIVERSITY OF SOUTHERN CALIFORNIA.

Nacionalidad solicitante: Estados Unidos de América.

Dirección: 3716 SOUTH HOPE STREET SUITE 313,LOS ANGELES, CA 90007-4344.

Inventor/es: MARCU, DANIEL, WONG,WILLIAM, KNIGHT,KEVIN, KOEHN,PHILIPP.

Fecha de Publicación: .

Fecha Concesión Europea: 21 de Abril de 2010.

Clasificación Internacional de Patentes:

- G06F17/28D2

- G06F17/28D4

Clasificación PCT:

- G06F17/28

Clasificación antigua:

- G06F17/28

Fragmento de la descripción:

Modelo de probabilidad de unión basado en frases para traducción automática estadística.

Origen de la invención

La investigación y el desarrollo descritos en esta solicitud fueron apoyados por DARPA-ITO con el número de subvención N66001-00-1-9814 y por las subvenciones del NSF-STTR 0128379. El Gobierno de los EE.UU. puede tener ciertos derechos en las invenciones reivindicadas.

Antecedentes

La mayoría de los modelos basados en canales de ruido utilizados en la traducción automática estadística (MT) son modelos de probabilidad condicional. En el marco del canal de ruido, cada oración fuente "e" en un cuerpo paralelo se supone que "genera" una frase destino "f" por medio de un proceso estocástico, cuyos parámetros se estiman mediante técnicas tradicionales de Máxima Expectación (EM). El modelo generativo explica cómo las palabras fuente se asignan a las palabras destino y cómo las palabras destino son reordenadas para producir oraciones destino bien formadas. Una variedad de procedimientos se utilizan para explicar el reordenamiento de las palabras destino, incluyendo los procedimientos que utilizan modelos basados en palabras, basados en plantillas, y basados en sintaxis (por nombrar sólo algunos). Aunque estos modelos utilizan diferentes procesos generativos para explicar cómo las palabras traducidas vuelven a ordenarse en un idioma de destino, a nivel de léxico estos modelos asumen que las palabras fuente son traducidas individualmente en palabras destino.

En el documento "Towards a Unified Approach to Memory - and Statistical-Based Machine Translation" de Daniel Marcu, Procedimiento de ACL-2001, se describe un procedimiento estadístico conocido de traducción automática que incluye un modelo de probabilidad conjunta basado en palabras, que es posteriormente formado para desarrollar una memoria de traducción para la correspondencia frase a frase. Otras referencias de interés como antecedentes incluyen "The Mathematics of Statistical Machine Translation: Parameter Estimation" de P Brown et al, Computacional Linguistics, Cambridge, MA; "Empirical Methods for Exploiting Parallel Texts" de Dan Melamed, The MIT Press. "Improved Alignment Models for Statistical Machine Translation", de Franz Josef Och et al, Procedures of the Joint Conference of Empirical Methods in Natural Language Processing and Very Large Corpora fue más allá de los modelos de traducción automática estadísticos originales permitiendo traducir unidades de múltiples palabras o frases.

Descripción

La invención se define en las reivindicaciones independientes a las que se ahora debe hacerse referencia. Características ventajosas se indican en las reivindicaciones dependientes.

Un sistema de traducción automática (MT) puede desarrollar diccionarios de traducción frase a frase probabilísticos utilizando una o más recopilaciones bilingües. Por ejemplo, pueden desarrollarse diccionarios de traducción utilizando un procedimiento de probabilidad conjunta, un procedimiento condicional de palabra a palabra, u otro procedimiento.

El sistema de MT puede traducir una o varias frases (o fragmentos de frase) utilizando diccionarios de traducción. Por ejemplo, el sistema de MT puede utilizar un procedimiento voraz, un procedimiento que utiliza un decodificador haz de pila u otro procedimiento para descifrar frases.

En las implementaciones en las que los diccionarios de traducción se desarrollan mediante un modelo de probabilidad conjunta basada en la frase, las frases fuente y destino del idioma se puede generar de forma simultánea. El sistema podrá utilizar el modelo de probabilidad conjunta tanto para aplicaciones de traducción fuente-a-destino y destino-a-fuente.

En realizaciones que usan un procedimiento condicional palabra-a-palabra, el modelo puede aprender alineaciones frase-a-frase a partir de alineaciones palabra-a-palabra generada por un sistema MT estadístico palabra-a-palabra.

Breve descripción de los dibujos

La figura 1 es un diagrama de bloques de un sistema de traducción automática (MT) que incluye un modelo de traducción de probabilidad conjunta basado en la frase.

La figura 2 muestra las alineaciones y distribuciones de probabilidad generadas por el modelo de probabilidad conjunta basado en la frase.

La Figura 3 es un diagrama de flujo que describe un algoritmo de entrenamiento para el modelo de probabilidad conjunta basado en la frase.

La Figura 4 se muestra un ejemplo de decodificación voraz basado en la frase.

La figura 5 es un diagrama de flujo que describe un algoritmo de decodificación basado en la frase según un ejemplo.

La Figura 6 muestra un pseudocódigo que describe el algoritmo de decodificación basado en la frase.

La figura 7 es un diagrama que muestra la generación de un arco entre las hipótesis.

La figura 8 es un gráfico que muestra el efecto de la longitud de la frase en el rendimiento.

La figura 9 muestra un ejemplo de estimación de un peso léxico.

La Figura 10 es un gráfico que muestra el efecto de la ponderación léxica en el rendimiento.

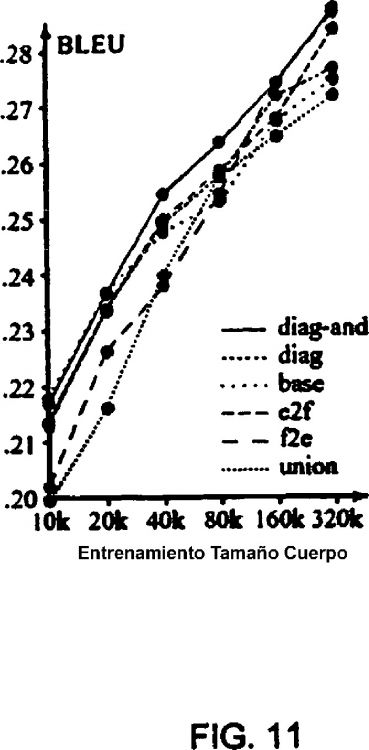

La figura 11 es un gráfico de comparación de la eficiencia de heurísticas diferentes.

Descripción detallada

Se pueden utilizar sistemas y técnicas de la presente divulgación para proporcionar una traducción automática (MT) más eficaz y exacta. En algunas implementaciones, el sistema de MT puede desarrollar diccionarios probabilísticos de traducción frase-a-frase. Los diccionarios de traducción probabilística pueden ser aprendidos de forma automática a partir de cuerpo bilingüe utilizando, por ejemplo, modelos de probabilidad conjunta o modelos condicionales palabra-a-palabra.

Estos diccionarios de traducción a continuación, se pueden utilizar para traducir frases nuevas. Es decir, los diccionarios de traducción se pueden utilizar para traducir frases no incluidas en los cuerpos utilizados para entrenar el sistema de MT. Sistemas y técnicas de traducción incluyen un procedimiento voraz, un procedimiento que utiliza un decodificador de haz de pila, u otros procedimientos.

La figura 1 muestra un sistema de traducción automática (MT) 100 incluyendo un modelo de traducción 105 y un decodificador 110. El modelo de traducción 105 puede incluir diccionarios de traducción que se pueden aprender a partir de cuerpo bilingües. El modelo de traducción 105 puede suponer que las correspondencias léxicas se pueden establecer al nivel de palabra y también al nivel de expresión. El decodificador 110 puede usar los diccionarios de traducción para proporcionar una frase traducida, sobre la base de una oración de entrada.

Desarrollo del diccionario de traducción de frase-a-frases

De acuerdo con algunas realizaciones, el modelo 105 puede ser entrenado de acuerdo a un modelo de probabilidad conjunta. Es decir, el modelo 105 puede desarrollar automáticamente un diccionario de traducción mediante un cuerpo paralelo 115 que incluye secuencias paralelas de idioma fuente y destino. El modelo 105 no trata de captar cómo las oraciones fuente pueden ser asignadas a frases destino, sino que genera frases fuente y destino de forma simultánea. En otras palabras, el modelo de traducción es un modelo de probabilidad conjunta que puede ser fácilmente marginado a fin de producir modelos de probabilidad condicional para ambas aplicaciones de traducción automática de fuente-a-destino y destino-a-fuente.

En una realización, el modelo 105 puede generar pares de oraciones usando el siguiente proceso estocástico:

1. Generar una bolsa de conceptos C.

2. Para cada concepto ci  , de acuerdo con la distribución t

, de acuerdo con la distribución t

3. Ordenar las frases generadas en cada idioma con el fin de crear dos secuencias lineales de frases; las secuencias corresponden a los pares de oraciones en un cuerpo bilingüe.

Por simplicidad, se supone que la bolsa de conceptos y el orden de las frases generadas se modelan mediante distribuciones uniformes. También se supone que ci =

Reivindicaciones:

1. Procedimiento implementado por ordenador para generar un modelo de probabilidad conjunta basado en frases a partir de un cuerpo paralelo que comprende una pluralidad de frases en el idioma fuente y una pluralidad de frases correspondiente en el idioma de destino;

comprendiendo el procedimiento:

a) definir a partir del cuerpo paralelo n-gramas de alta frecuencia (

b) obtener una distribución de probabilidad conjunta t inicial basada en la frase, mediante:

c) realizar el entrenamiento de Expectativa Máxima para una pluralidad de iteraciones para generar una distribución de probabilidad conjunta t.

2. Procedimiento según la reivindicación 1, que comprende repetir las etapas a) a c) con unigramas en lugar de n-gramas.

3. Procedimiento según la reivindicación 1 ó 2, que comprende generar un modelo de probabilidad condicional a partir del modelo de probabilidad conjunta, donde el modelo de probabilidad condicional puede ser utilizado posteriormente para la decodificación.

4. Procedimiento según la reivindicación 1 ó 2, que comprende además:

generar un diccionario de traducción frase-a-frase del modelo de probabilidad conjunta y el cuerpo paralelo.

5. Procedimiento según la reivindicación 4, en el que se genera el diccionario de la traducción frase-a-frase, mediante:

i) generar estocásticamente una bolsa de conceptos C;

ii) generar y descubrir un único conjunto de conceptos ocultos ci  de acuerdo con la distribución t

de acuerdo con la distribución t , donde cada

, donde cada

iii) ordenar las frases generadas en cada idioma con el fin de crear dos secuencias lineales de frases.

6. Procedimiento según la reivindicación 4, en el que el diccionario de traducción frase-a-frase se genera mediante:

(1) generar estocásticamente una bolsa de conceptos C;

(2) inicializar E y F para vaciar las frases

(3) eliminar al azar un concepto ci

(4) añadir la frase

(5) insertar de la frase

donde

repetir las etapas (3) a (5) hasta que C esté vacío.

7. Procedimiento según la reivindicación 1, que comprende la generación de un diccionario de traducción frase-a-frase a partir de un cuerpo paralelo usando alineaciones palabra-por-palabra en el cuerpo paralelo y un modelo basado en la frase.

8. Procedimiento según la reivindicación 7, en el que dicha generación comprende:

realizar una alineación palabra-a-palabra en ambos lados del cuerpo paralelo para producir una pluralidad de alineaciones de palabra, y

recoger una pluralidad de pares de palabras alineadas que están en consonancia con las alineaciones de palabras en dicha pluralidad de alineaciones de palabras.

9. Procedimiento según la reivindicación 8, que comprende además:

estimar una distribución de probabilidad de traducción de frases a partir de los pares de palabras recogidas mediante frecuencias relativas.

10. Procedimiento según la reivindicación 9, que comprende además:

analizar ambos lados del cuerpo paralelo de palabras-alineadas con un analizador sintáctico para generar árboles sintácticos y

para cada par de palabras alineadas, comprobar si las dos frases son subárboles en los árboles sintácticos analizados.

11. Procedimiento según la reivindicación 9, que comprende además:

identificar un par de frases recogidas alineadas que tiene una pluralidad de alineaciones; y

calcular un peso léxico para cada una de dichas pluralidades de alineaciones.

12. Procedimiento según la reivindicación 7, en el que dicha generación comprende:

realizar operaciones de alineación bidireccional palabra-a-palabra en el cuerpo paralelo para generar dos juegos de alineaciones de palabras.

13. Procedimiento según la reivindicación 12, que comprende además:

identificar los puntos de la alineación en las intersecciones entre los dos juegos de alineaciones de palabras.

14. Procedimiento según la reivindicación 12, que comprende además:

identificar los puntos de alineación en la unión entre los dos juegos de alineaciones de palabras.

15. Procedimiento según cualquiera de las reivindicaciones 1 a 6, que comprende además: determinar una traducción para una frase de entrada en el primer idioma mediante una operación de decodificación voraz.

16. Procedimiento según la reivindicación 15, que comprende además la determinación de la mejor frase de salida en un segundo idioma para una frase de entrada en un primer idioma mediante

segmentar la oración de entrada en una secuencia de la frase;

traducir cada una de dichas frases en una frase en el segundo idioma, y

reordenar las frases de salida.

17. Procedimiento según la reivindicación 16, en el que dicha reordenación comprende reordenar las frases de salida utilizando una distribución de probabilidad de distorsión relativa.

18. Procedimiento según cualquiera de las reivindicaciones 1 a 6, que comprende además:

determinar una traducción para una frase de entrada en el primer idioma utilizando un algoritmo de búsqueda en haz.

19. Procedimiento según la reivindicación 2 ó 3, que comprende:

(1) recibir una cadena de entrada que incluye una pluralidad de palabras en un primer idioma;

(2) crear una hipótesis inicial es un segundo idioma, en la que la hipótesis inicial representa una traducción parcial de la cadena de entrada en el segundo idioma que contiene cero o más palabras;

(3) seleccionar una secuencia de dicha pluralidad de palabras en la cadena de entrada:

(4) seleccionar una posible traducción de frase en el segundo idioma mediante el modelo de probabilidad conjunta o condicional para dicha secuencia seleccionada;

(5) adjuntar la posible traducción de la frase a las actuales hipótesis para obtener una hipótesis actualizada;

(6) marcar las palabras en dicha secuencia seleccionada según la traducción;

(7) guardar la secuencia de hipótesis en una pila;

(8) actualizar un costo de probabilidad de la hipótesis de actualización;

(9) repetir las etapas (3) a (8) sobre la base de un tamaño de la pila para producir una o varias traducciones posibles de la cadena de entrada, y

(10) seleccionar una de dichas traducciones posibles de la pila con la más alta probabilidad.

20. Procedimiento según la reivindicación 19, en el que cada una de las posibles traducciones comprende una hipótesis que deja palabras sin traducir no correspondientes en la cadena de entrada.

21. Procedimiento según la reivindicación 19, en el que dicha actualización del coste de probabilidad consiste en realizar un coste actual para la hipótesis de actualización y estimar un coste futuro para la hipótesis actualizada.

22. Procedimiento según la reivindicación 21, que comprende además:

descartar una secuencia de salida actualizada si dicha hipótesis actualizada tiene un costo mayor que las n hipótesis mejores en la pila, donde n corresponde a un tamaño de haz predeterminado.

23. Procedimiento según cualquier reivindicación anterior, en el que el entrenamiento EM es un entrenamiento EM basado en Viterbi.

Patentes similares o relacionadas:

PROCDEDIMIENTO Y SISTEMA DE TRADUCCION DE IDIOMAS POR FRASES HOMOLOGAS, del 16 de Junio de 2008, de SANCHEZ GOMEZ,GINES: Procedimiento y sistema de traducción de idiomas por frases homólogas. Dos colecciones homólogas de frases en dos idiomas Origen y Destino. […]

Dispositivo de traducción con sistema automático de conmutación de salida de audio, del 10 de Mayo de 2017, de OCHOA VALEZ, Rómulo Antonio: 1. Dispositivo de traducción con sistema automático de conmutación de salida de audio; caracterizado porque comprende: - un cuerpo acoplable a […]

Procedimientos, aparatos y productos para el procesamiento semántico de texto, del 16 de Noviembre de 2016, de cortical.io GmbH: Procedimiento implementado por ordenador para generar un diccionario legible por ordenador para traducir texto en una forma legible por una red neuronal, que comprende: […]

Gestión de gráficos multilingües para retransmisiones televisivas, del 12 de Octubre de 2016, de INSTITUT FUR RUNDFUNKTECHNIK GMBH: Aparato de gráficos sobreimpresionados en pantalla para inserción de gráficos en una señal de televisión con: - una entrada para […]

Procedimiento de cálculo de correspondencias de traducción entre palabras de diferentes idiomas, del 7 de Septiembre de 2016, de Microsoft Technology Licensing, LLC: Un procedimiento implementado por ordenador para calcular correspondencias de traducción entre palabras, que comprende: calcular puntuaciones de asociación de palabras […]

SISTEMA, MÉTODO Y MEDIO LEGIBLE POR COMPUTADORA DE INTERFAZ DE LENGUAJE, del 13 de Agosto de 2015, de ALVAREZ HEINEMEYER, Marco: Se describe un sistema y método de interfaz de lenguaje para ser usado, preferiblemente, por las personas sordas, con discapacidad auditiva, mudas o con discapacidad visual. […]

Procedimiento, servidor y sistema para la transcripción de lengua hablada, del 25 de Diciembre de 2013, de VerbaVoice GmbH: Un procedimiento de transcripción para la transcripción de lengua hablada en texto continuo para un usuario (U) que comprende las etapas de: (a) introducir una lengua […]

Procedimiento y dispositivo para la adaptación de ficheros digitales, del 23 de Octubre de 2013, de AMADEUS S.A.S.: Procedimiento de adaptación de ficheros digitales que consiste en determinar cadenas de caracteresdenominadas fuentes en un fichero de programa que se va a […]