PROCEDIMIENTO Y DISPOSITIVO PARA SINCRONIZAR SUBTÍTULOS CON AUDIO EN SUBTITULACIÓN EN DIRECTO.

La sincronización de subtítulos y audio en directo que se propone determina un retardo de subtítulo individual {dl}ti de cada subtítulo i y crea una unidad de subtítulo Si con el subtítulo i y el retardo de subtítulo individual {dl}ti.

Cada unidad de subtítulo Si se introduce en uno o más paquetes PES de subtítulo con una marca de tiempo de presentación PTSi y junto con un retardo de desplazamiento asociado configurable REST. Dichos paquetes forman parte de un flujo de transporte extendido que incluye paquetes de audio que contiene al menos un fragmento de audio j y una marca de tiempo de presentación PTSj. Se realiza una sincronización de los paquetes de subtítulo con paquetes de audio creando un flujo de transporte sincronizado que comprende todos los paquetes del flujo de transporte extendido retardados un tiempo que depende de un l retardo de desplazamiento asociado configurable REST.

Tipo: Patente de Invención. Resumen de patente/invención. Número de Solicitud: P201030758.

Solicitante: UNIVERSIDAD CARLOS III DE MADRID.

Nacionalidad solicitante: España.

Inventor/es: RUIZ MEZCUA, BELEN, DE CASTRO ÁLVAREZ,MERCEDES, DE PEDRO SASTRE,Manuel, JIMENEZ DORADO,Javier.

Fecha de Publicación: .

Clasificación Internacional de Patentes:

- H04N7/24 ELECTRICIDAD. › H04 TECNICA DE LAS COMUNICACIONES ELECTRICAS. › H04N TRANSMISION DE IMAGENES, p. ej. TELEVISION. › H04N 7/00 Sistemas de televisión (detalles H04N 3/00, H04N 5/00; métodos y arreglos, para la codificación, decodificación, compresión o descompresión de señales de vídeo digital H04N 19/00; distribución selectiva de contenido H04N 21/00). › Sistemas para la transmisión de señales de televisión que utilizan la modulación por impulsos codificados (H04N 21/00 tiene prioridad).

Fragmento de la descripción:

Procedimiento y dispositivo para sincronizar subtítulos con audio en subtitulación en directo.

Campo técnico de la invención

La presente invención tiene su aplicación en el campo de la generación de subtítulos para eventos multimedia en directo, por ejemplo programas de televisión o radio en directo, para su visualización en tiempo real y sincronizados tanto con el audio como con el vídeo.

Antecedentes de la invención

Los subtítulos, como modo de acceder al contenido de audio de eventos multimedia suministrado a través de gran diversidad de dispositivos (equipos de televisión, teléfonos móviles 3G, ordenadores, ...) son necesarios para personas con dificultades auditivas o personas que necesitan cierta ayuda para entender el idioma. Los subtítulos también son necesarios cuando se experimentan contenidos multimedia en entornos ruidosos o lugares en los que debe desactivarse el sonido.

Aunque la subtitulación de eventos que no son en directo es una práctica normal hoy en día, la subtitulación de eventos en directo es menos frecuente debido a la complejidad inherente de la tecnología actual. La subtitulación en tiempo real de eventos audiovisuales es una investigación pluridisciplinar que abarca tecnologías de los campos de reconocimiento automático del habla, informática y transmisión y difusión de paquetes en red. En eventos en directo en los que los subtítulos se presentan en una pantalla auxiliar, pero el vídeo y el audio se experimentan directamente, no existe la oportunidad de gestionar el retardo de los subtítulos. Lleva tiempo crear subtítulos a partir del habla, independientemente del procedimiento usado para la transcripción de audio a texto. En las mejores condiciones, el retardo en la creación de subtítulos de texto puede ser de varios segundos. Cualquier procedimiento que intente tratar el problema del retardo entre audio y subtítulos debe proporcionar un procedimiento para determinar la correspondencia temporal entre un fragmento de audio y los subtítulos generados a partir del mismo.

En el actual estado de la técnica para la generación de subtítulos en programas de televisión en directo, siempre hay un retardo significativo y variable entre el audio y el momento en el tiempo en el que están listos los subtítulos correspondientes. Como resultado, los subtítulos se muestran en la pantalla del usuario un número variable de segundos después y por tanto de manera no sincronizada con el audio/vídeo. Para entender mejor los procesos implicados en la subtitulación en directo (10) , la figura 1 muestra las etapas relevantes:

Etapa 1)

Transcripción de audio (1) : la transcripción inmediata de habla a partir de uno o varios hablantes a texto.

Etapa 2)

Generación de subtítulos (2) : la generación de subtítulos a partir de texto.

Etapas3y4)

Segmentación en paquetes (3) y transmisión/difusión (4) a través de los sistemas multimedia, por ejemplo, televisión digital terrestre (41) , Internet (42) , televisión por protocolo de Internet (43) , etc.

Etapa 5)

Recepción y presentación (5) en la pantalla del usuario en, por ejemplo, un receptor de televisión (51) , un ordenador (52) , un teléfono móvil 3G o una televisión convencional con un codificador de IPTV (53) , por mencionar sólo unos cuantos.

En entornos de generación de subtitulación en directo, el proceso de transcripción de audio (1) suministra el texto correspondiente varios segundos después de haber recibido el fragmento de habla. La transcripción de habla en texto en tiempo real es la causa originaria de los retardos de los subtítulos y es muy difícil de minimizar. En el pasado reciente y todavía hoy, el principal enfoque para la transcripción de audio (1) a texto a partir del habla ha sido el uso de estenotipia (11) en la que el texto transcrito a partir del audio se produce manualmente por estenotipistas. Aunque la calidad y velocidad de la estenotipia (11) son buenas, el coste de este proceso y la baja disponibilidad de estenotipistas hacen difícil que se convierta en una práctica extendida en la subtitulación masiva de eventos en tiempo real. Otra alternativa es el uso de ASR o motores de reconocimiento automático del habla (12) aplicados al audio del hablante, o bien directamente o a través de un rehablador intermedio (13) , para reconocer automáticamente las palabras y frases con una mínima intervención humana. Los principales inconvenientes de la subtitulación con la tecnología de ASR actual son los retardos introducidos en los subtítulos con respecto a los flujos de vídeo y audio originales, las tasas de error de reconocimiento de habla y la necesidad de entrenar el sistema para la voz y el vocabulario del hablante.

En la práctica, puede usarse ASR con la ayuda de un operador humano que manipula el texto de salida para mejorar

o corregir los subtítulos. De hecho, para la subtitulación en directo de televisión, el uso de rehablado y manipulación es una práctica normal. El uso de ASR directamente sin un rehablador intermedio implica o bien aplicar un ASR independiente del hablante a cualquier voz en la señal de audio, o aplicar un ASR dependiente del hablante entrenado previamente para las diferentes voces en la señal de audio. El ASR basado en rehablado, en el que una persona habla a un ASR dependiente del hablante, tratando de repetir lo que está escuchando, es de los más usados en difusión de televisión en tiempo real en todo el mundo en la actualidad, por ejemplo, en el Reino Unido o en España. La estenografía se ha usado y todavía se usa ampliamente para subtitulación en tiempo real, por ejemplo en EE. UU., en conexión con un ordenador en el que una aplicación de software traduce los símbolos estenográficos en texto. Hay otros procedimientos, no muy comunes pero que se usan en ocasiones para subtitulación en tiempo real, tales como teclear directamente mediante un teclado o usar un teclado silábico tal como VeyboardTM.

Para la generación de subtitulación (2) , los subtítulos se crean a partir de los fragmentos de texto transcritos recibidos desde el subsistema de transcripción de audio (1) . El subsistema de generación de subtitulación (2) permite la corrección y el formateo manuales (21) , por ejemplo, asignando colores a los fragmentos de texto dependiendo de la información de hablante o de contexto, etc. Los subtítulos finales se suministran mediante el subsistema de subtitulación en directo (22) junto con otra información importante para su presentación final, tal como la duración (tiempo de permanencia en pantalla del subtítulo) , el color, la posición en la pantalla, etc.

El posterior proceso de segmentación en paquetes (3) de los flujos de vídeo, audio y subtítulos genera paquetes de flujo de transporte (31) que se envían a través de sistemas de transmisión (4) : por ejemplo por televisión digital

o por IP. Cada paquete transmitido contiene, además de la carga útil e, independientemente de su tipo (vídeo, audio

o datos) , una indicación de un tiempo para la presentación en pantalla (presentation_time_stamp) , que se usa en el lado de recepción para una presentación sincronizada de paquetes pertenecientes a los diferentes flujos de un canal de televisión. Dentro de los paquetes de flujo de transporte (31) , hay también una referencia de reloj global (100) para la sincronización temporal, de modo que todas las marcas de tiempo de presentación hacen referencia a la misma referencia de reloj común.

Lo que es importante entender es que estas marcas de tiempo de presentación se calculan en el lado de emisión según el reloj en tiempo real (100) del sistema y corresponden al momento en el tiempo en el que se crean los paquetes de flujo de transporte (31) . El resultado es que se mantienen los retardos entre audio/vídeo y subtítulos, es decir, los paquetes de audio y vídeo tienen marcas de tiempo de presentación que preceden en el tiempo a las marcas de tiempo de presentación de sus subtítulos correspondientes. En el lado de recepción, el usuario sólo detecta esta falta de alineación entre los flujos cuando activa los subtítulos. Mientras que los flujos de audio y vídeo están sincronizados entre sí, los subtítulos se presentan varios segundos después y nunca se corresponden con el audio y vídeo en la pantalla.

Sumario de la invención

La presente invención sirve para...

Reivindicaciones:

1. Procedimiento para sincronizar subtítulos con audio en sistemas de subtitulación en directo, que comprende:

- generar al menos un subtítulo i a partir de al menos un bloque de transcripción Tj que corresponde a un fragmento de audio j;

caracterizado porque comprende además:

- determinar un retardo de subtítulo individual Δti de cada subtítulo i;

- crear una unidad de subtítulo Si que comprende el subtítulo i y el retardo de subtítulo individual Δti;

- poner cada unidad de subtítulo Si junto con un retardo de desplazamiento asociado configurable REST en al menos un paquete de subtítulo PES, el cual tiene una marca de tiempo de presentación PTSi, formando dichos paquetes de subtítulo PES parte de un flujo de transporte extendido que incluye al menos un paquete de audio que contiene el fragmento de audio j y una marca de tiempo de presentación PTSj.

- sincronizar paquetes de subtítulo PES con paquetes de audio creando un flujo de transporte sincronizado que comprende todos los paquetes del flujo de transporte extendido retardados un tiempo que depende del retardo de desplazamiento asociado configurable REST.

2. Procedimiento según la reivindicación 1, en el que la sincronización de paquetes de subtítulo PES con paquetes de audio comprende retardar cada paquete de subtítulo PES asociándole una marca de tiempo de presentación en el flujo de transporte sincronizado que es igual a PTSi-Δti+REST, y retardar cada paquete de audio asociándole una marca de tiempo de presentación en el flujo de transporte sincronizado que es igual a PTSj+REST, siendo PTSi y PTSj las marcas de tiempo de presentación en el flujo de transporte extendido y REST el retardo de desplazamiento asociado del flujo de transporte extendido.

3. Procedimiento según la reivindicación 2, en el que, si el flujo de transporte extendido incluye al menos un paquete de vídeo o al menos un paquete de datos de cualquier clase de datos sincronizables con paquetes de audio, la sincronización de paquetes de subtítulo comprende además retardar todos los paquetes de vídeo y de datos un tiempo que depende del retardo de desplazamiento asociado configurable REST.

4. Procedimiento según cualquiera de las reivindicaciones 1 a 3, en el que la sincronización de paquetes de subtítulo con paquetes de audio se realiza antes de transmitir el flujo de transporte sincronizado a un dispositivo de recepción digital.

5. Procedimiento según la reivindicación 4, que comprende recibir el flujo de transporte sincronizado en el dispositivo de recepción digital, que es un receptor convencional seleccionado de un receptor de radiodifusión digital, un módulo decodificador de televisión digital terrestre, un receptor de televisión por IP, un receptor de difusión multimedia digital y un receptor de medios digital con medios de control para televisión en directo.

6. Procedimiento según cualquiera de las reivindicaciones 1 a 3, en el que la sincronización de paquetes de subtítulo con paquetes de audio se realiza después de recibir el flujo de transporte extendido en un dispositivo de recepción digital.

7. Procedimiento según la reivindicación 6, que comprende además permitir a un usuario elegir si la sincronización de paquetes de subtítulo con paquetes de audio es realizada por el dispositivo de recepción digital o no.

8. Procedimiento según cualquiera de las reivindicaciones 6 a 7, que comprende recibir el flujo de transporte extendido en el dispositivo de recepción digital, que se selecciona de un receptor de radiodifusión digital, un módulo decodificador de televisión digital terrestre, un receptor de televisión por IP, un receptor de difusión multimedia digital y un receptor de medios digital con medios de control para televisión en directo.

9. Procedimiento según cualquiera de las reivindicaciones 1 a 3, en el que la sincronización de paquetes de subtítulo con paquetes de audio se realiza antes de almacenar el flujo de transporte sincronizado en un soporte de almacenamiento multimedia.

10. Procedimiento según cualquiera de las reivindicaciones1a3, enelque la sincronización de paquetes de subtítulo con paquetes de audio se realiza después de almacenar el flujo de transporte extendido en un soporte de almacenamiento multimedia y antes de transmitir el flujo de transporte sincronizado a una red de distribución multimedia, que se selecciona de una red de IP, una red de difusión de televisión digital terrestre y una red de radiodifusión digital.

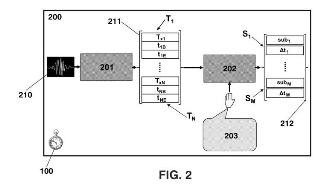

11. Procedimiento según cualquier reivindicación anterior, en el que la determinación de un retardo de subtítulo individual Δti de cada subtítulo i comprende:

- determinar una marca de tiempo de comienzo tjB que es el momento en el que comienza el primer fragmento de audio correspondiente al primer bloque de transcripción Tj de un grupo de bloques de transcripción, el grupo formado por al menos un bloque de transcripción y creado por un subsistema de transcripción de audio 201, y a partir del cual se genera al menos una unidad de subtítulo Si mediante un subsistema de generación de subtítulos 202, con respecto a un reloj de referencia 100, usándose el reloj de referencia 100 tanto por el subsistema de generación de subtítulos 202 como por el subsistema de transcripción de audio 201;

- determinar un tiempo de entrega tsubi que es cuando se entrega el primer subtítulo generado a partir de dicho grupo de bloques de transcripción por el subsistema de generación de subtítulos 202;

- restar la marca de tiempo de comienzo tjB de dicho primer fragmento de audio del tiempo de entrega tsubi para calcular el retardo de subtítulo individual Δti = tsubi -tjB;

- asignar dicho retardo de subtítulo individual Δti a cada unidad de subtítulo Si creada a partir de dicho grupo de bloques de transcripción.

12. Procedimiento según la reivindicación 11, que comprende además determinar una marca de tiempo de finalización tjE que es el momento en el que finaliza el primer fragmento de audio correspondiente al primer bloque de transcripción Tj del grupo de bloques de transcripción, con respecto al reloj de referencia 100.

13. Procedimiento según la reivindicación 12, en el que el subsistema de transcripción de audio 201 usa una transcripción mental por parte de una persona y la marca de tiempo de comienzo tjB y la marca de tiempo de finalización tjE se estiman respectivamente como tjB =thjB + Δtmpj ytjE =thjE + Δtmpj calculando un retardo de procesamiento mental Δtmpj que depende del tipo de transcripción mental, que se selecciona de transcripción mental continua y transcripción mental discreta, thjB es un instante de tiempo marcado cuando la persona comienza la transcripción mental y thjE es un instante de tiempo marcado cuando la persona finaliza la transcripción mental, ambos tiempos dados automáticamente por el subsistema de transcripción de audio 201 con respecto al reloj de referencia 100.

14. Procedimiento según la reivindicación 13, en el que el retardo de procesamiento mental Δtmpj es una constante fijada por el subsistema de transcripción de audio 201 cuando usa transcripción mental continua.

15. Procedimiento según la reivindicación 13, en el que el retardo de procesamiento mental Δtmpj se calcula por el subsistema de transcripción de audio 201 cuando usa transcripción mental discreta como Δtmpj = TextLengthj · (K/μ)

+ C, siendo TextLengthj una longitud en unidades de longitud del fragmento de audio j, K es la duración de tiempo de una unidad de longitud; C es una constante de tiempo configurable en el subsistema de transcripción de audio 201, y μ es una variable de grado de literalidad, 0≤μ≤1, configurable y que representa la proximidad de la transcripción mental a la literalidad.

16. Dispositivo sincronizador de subtítulos, caracterizado porque comprende medios de procesamiento configurados para:

- crear un flujo de transporte extendido a partir de un flujo de transporte inicial que comprende todos los paquetes del flujo de transporte inicial, los cuales tienen una marca de tiempo de presentación asociada, comprendiendo el flujo de transporte extendido:

al menos un paquete de audio que contiene un fragmento de audio j,

al menos una unidad de subtítulo Si que comprende un subtítulo i generado a partir de al menos un bloque de transcripción Tj que corresponde al fragmento de audiojyun determinado retardo de subtítulo individual Δti asociado a cada subtítulo i,

y un retardo de desplazamiento asociado REST que es configurable e indica un retardo fijo para sincronizar paquetes de subtítulo con paquetes de audio,

- ajustar la marca de tiempo de presentación asociado de cada paquete de subtítulo del flujo de transporte extendido asociándole una marca de tiempo de presentación en el flujo de transporte sincronizado que es igual a PTSiΔti+REST, y retardar cada paquete de audio asociándole una marca de tiempo de presentación en el flujo de transporte sincronizado que es igual a PTSj+REST, siendo PTSi yPTSj unas marcas de tiempo de presentación asociadas en el flujo de transporte extendido al paquete de subtítulo y el paquete de audio respectivamente y REST el retardo de desplazamiento asociado en el flujo de transporte extendido.

17. Dispositivo sincronizador de subtítulos según la reivindicación 16, en el que, si el flujo de transporte inicial incluye al menos un paquete de vídeo o al menos un paquete de datos de cualquier clase de datos sincronizables con paquetes de audio, los medios de procesamiento están configurados para retardar todos los paquetes de vídeo y de datos el tiempo de desplazamiento global.

18. Dispositivo sincronizador de subtítulos según cualquiera de las reivindicaciones 16 a 17, en el que los medios de procesamiento están configurados para crear el flujo de transporte sincronizado antes de transmitir dicho flujo a un dispositivo de recepción digital.

19. Dispositivo sincronizador de subtítulos según cualquiera de las reivindicaciones 16 a 17, en el que los medios de procesamiento están configurados para permitir a un usuario elegir si la creación del flujo de transporte sincronizado se realiza después de recibir el flujo de transporte extendido en un dispositivo de recepción digital.

20. Dispositivo sincronizador de subtítulos según la reivindicación 19, que está integrado en el dispositivo de recepción digital seleccionado de un receptor de radiodifusión digital, un módulo decodificador de televisión digital terrestre, un receptor de televisión por IP, un receptor de difusión multimedia digital y un receptor de medios digital con medios de control para televisión en directo.

21. Dispositivo sincronizador de subtítulos según cualquiera de las reivindicaciones 16 a 17, en el que los medios de procesamiento están configurados para crear el flujo de transporte sincronizado antes de almacenar dicho flujo en un soporte de almacenamiento multimedia.

22. Dispositivo sincronizador de subtítulos según cualquiera de las reivindicaciones 16 a 17, en el que los medios de procesamiento están configurados para crear el flujo de transporte sincronizado a partir de un flujo de transporte extendido almacenado previamente en un soporte de almacenamiento multimedia y antes de transmitir el flujo de transporte sincronizado a una red de distribución multimedia, que se selecciona de una red de IP, una red de difusión de televisión digital terrestre y una red de radiodifusión digital.

23. Un producto de programa informático que comprende medios de código de programa que, cuando se cargan en un procesador de propósito general, un procesador de señal digital, circuitos integrados de aplicación específica o cualquier dispositivo lógico programable, hace que dichos medios de código de programa ejecuten el procedimiento según cualquiera de las reivindicaciones1a15.

Patentes similares o relacionadas:

Procedimiento de transferencia de datos y aparato que opera insertando otro contenido en el contenido principal, del 17 de Junio de 2020, de SAMSUNG ELECTRONICS CO., LTD.: Un procedimiento de reproducción de datos multimedia, por un cliente, comprendiendo el procedimiento: solicitar y recibir un primer archivo que […]

Sincronización de flujo modificado, del 6 de Mayo de 2020, de KONINKLIJKE KPN N.V.: Método para permitir la sincronización entre destinos de al menos un primer y al menos un segundo flujo, estando asociado dicho segundo flujo con el […]

Procedimiento y aparato para la encapsulación de activos de transporte de medios del grupo de expertos en imágenes en movimiento dentro de la organización internacional de normalización de archivos de medios de base, del 6 de Mayo de 2020, de SAMSUNG ELECTRONICS CO., LTD.: Un procedimiento para transmitir datos de medios mediante una entidad emisora en un sistema de transporte de medios MMT de MPEG, comprendiendo el […]

Sistema y método para codificación y decodificación aritmética, del 29 de Abril de 2020, de NTT DOCOMO, INC.: Método de decodificación aritmética para convertir una secuencia de información compuesta por una secuencia de bits en una secuencia de eventos binarios compuesta […]

Adaptación de un flujo de datos escalables con inclusión de unas retransmisiones, del 19 de Febrero de 2020, de Orange: Un procedimiento de adaptación de un flujo de datos escalable que comprende unas primeras unidades de datos (O_Data) y que define una pluralidad […]

Transmisión de solicitud de bloque mejorada usando http cooperativa paralela y corrección de errores hacia adelante, del 30 de Octubre de 2019, de QUALCOMM INCORPORATED: Un procedimiento para su uso en un sistema de comunicación en el que un dispositivo cliente solicita segmentos de medios desde un sistema de ingestión […]

Transmisión de solicitud de bloque mejorada usando http cooperativa paralela y corrección de errores hacia adelante, del 30 de Octubre de 2019, de QUALCOMM INCORPORATED: Un procedimiento para su uso en un sistema de comunicación en el que un dispositivo cliente solicita segmentos de medios desde un sistema de ingestión […]

Sistema de demanda y reproducción de medios, del 23 de Octubre de 2019, de Sky CP Limited: Un receptor de medios adaptado para reproducir elementos de contenido de medios primarios y secundarios recibidos de un servidor de medios en respuesta a una […]

Procedimiento de presentación de flujos de velocidad adaptativa, del 28 de Agosto de 2019, de DISH Technologies L.L.C: Un procedimiento de presentación de flujos de velocidad adaptativa, comprendiendo el procedimiento: transmitir mediante un reproductor multimedia que opera en una […]

Procedimiento de presentación de flujos de velocidad adaptativa, del 28 de Agosto de 2019, de DISH Technologies L.L.C: Un procedimiento de presentación de flujos de velocidad adaptativa, comprendiendo el procedimiento: transmitir mediante un reproductor multimedia que opera en una […]